دستهبندی نشده

پیش پردازش داده ها

پیش پردازش داده ها (بررسی کامل بودن دیتاست، تبدیل داده های غیر عددی به عددی، نرمال کردن داده ها، داده های نویز و …)

دیتاست ها و پیش پردازش داده ها

یادگیری ماشینی به ما این امکان را می دهد که داده های زیادی را به پیش بینی هایی تبدیل کنیم که بتوانیم از توانایی های آنها در پروژه های مختلف بهره ببریم. با این حال، الگوریتمهای یادگیری ماشینی مؤثر (ML) برای انجام پیشبینیهای دقیق نیاز به آموزش و آزمایش دادههای با کیفیت – و اغلب تعداد زیادی از آنها دارند.

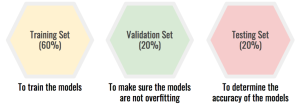

مجموعه دادههای مختلف در تهیه الگوریتمی برای پیشبینی و تصمیمگیری بر اساس دادههای دنیای واقعی اهداف متفاوتی دارند. در اینجا، دادههای آموزشی را با دادههای آزمایشی در مقابل دادههای اعتبارسنجی مقایسه میکنیم. در حالی که هر سه به طور معمول از یک مجموعه داده بزرگ جدا می شوند، هر کدام معمولاً کاربرد متمایز خود را در مدل سازی ML دارند.

داده های آموزشی و پیش پردازش داده ها

این نوع داده الگوریتم یادگیری ماشینی را ایجاد می کند. دانشمند داده، داده های ورودی الگوریتم را تغذیه می کند، که با خروجی مورد انتظار مطابقت دارد. مدل ها داده ها را به طور مکرر ارزیابی می کنند تا در مورد رفتار داده ها اطلاعات بیشتری کسب کند و سپس خود را برای خدمت به هدف مورد نظر خود تنظیم می کند.

داده های اعتبارسنجی و پیش پردازش داده ها

در طول آموزش، دادههای اعتبارسنجی دادههای جدیدی را به مدل وارد میکنند که قبلاً ارزیابی نشده است. دادههای اعتبارسنجی اولین آزمایش را در برابر دادههای دیده نشده ارائه میکند و به دانشمندان داده اجازه میدهد تا میزان پیشبینیهای مدل را بر اساس دادههای جدید ارزیابی کنند. همه دانشمندان داده از دادههای اعتبار سنجی استفاده نمیکنند، اما میتوانند اطلاعات مفیدی را برای بهینهسازی فراپارامترها فراهم کنند، که بر نحوه ارزیابی مدل تأثیر میگذارد.

داده های تست و پیش پردازش داده ها

پس از ساخته شدن مدل، داده های آزمایشی بار دیگر تایید می کند که می تواند پیش بینی های دقیقی انجام دهد. اگر دادههای آموزشی و اعتبارسنجی شامل برچسبهایی برای نظارت بر معیارهای عملکرد مدل باشد، دادههای آزمایش باید بدون برچسب باشند. دادههای آزمایشی یک بررسی واقعی و نهایی از مجموعه دادههای دیده نشده را فراهم میکند تا تأیید کند که الگوریتم ML به طور مؤثر آموزش داده شده است.

در حالی که هر یک از این سه مجموعه داده جایگاه خود را در ایجاد و آموزش مدلهای ML دارند، به راحتی میتوان همپوشانی بین آنها را مشاهده کرد. تفاوت بین دادههای آموزشی و دادههای آزمایشی واضح است: یکی یک مدل را آموزش میدهد، دیگری تأیید میکند که درست کار میکند.

داده های آموزش در برابر داده های اعتبار سنجی

الگوریتم های ML برای دستیابی به یک هدف به داده های آموزشی نیاز دارند. الگوریتم این مجموعه داده آموزشی را تجزیه و تحلیل میکند، ورودیها و خروجیها را طبقهبندی میکند، سپس دوباره آن را تحلیل میکند. الگوریتمی که بیش از حد آموزش دیده باشد، اساساً تمام ورودی ها و خروجی های یک مجموعه داده آموزشی را به خاطر می سپارد – این زمانی که نیاز به در نظر گرفتن داده ها از منابع دیگر، مانند مشتریان دنیای واقعی دارد، مشکل ساز می شود.

در اینجا اطلاعات اعتبارسنجی مفید است. دادههای اعتبارسنجی یک بررسی اولیه را فراهم میکند که مدل میتواند پیشبینیهای مفید را در یک محیط واقعی برگرداند، که دادههای آموزشی نمیتوانند انجام دهند. الگوریتم ML می تواند داده های آموزشی و داده های اعتبار سنجی را همزمان ارزیابی کند.

داده های اعتبار سنجی یک بخش کاملاً مجزا از داده ها است، اگرچه یک دانشمند داده ممکن است بخشی از مجموعه داده های آموزشی را برای اعتبار سنجی بسازد – تا زمانی که مجموعه داده ها در کل آموزش و آزمایش جداگانه نگه داشته شوند.

برای مثال، فرض کنید یک الگوریتم ML قرار است تصویری از یک مهرهدار را تجزیه و تحلیل کند و طبقهبندی علمی آن را ارائه دهد. مجموعه داده آموزشی شامل تعداد زیادی عکس از پستانداران است، اما نه همه تصاویر همه پستانداران، چه رسد به همه تصاویر همه مهره داران.

بنابراین، وقتی دادههای اعتبارسنجی تصویری از یک سنجاب ارائه میدهند، حیوانی که مدل قبلاً ندیده است، دانشمند داده میتواند ارزیابی کند که الگوریتم در آن کار چقدر خوب عمل میکند. این یک بررسی در برابر مجموعه داده های کاملاً متفاوت با مجموعه ای است که در آن آموزش داده شده است.

بر اساس دقت پیشبینیها پس از مرحله اعتبارسنجی، دانشمندان داده میتوانند فراپارامترهایی مانند نرخ یادگیری، ویژگیهای ورودی و لایههای پنهان را تنظیم کنند. این تنظیمات از تطبیق بیش از حد جلوگیری میکند، که در آن الگوریتم میتواند تصمیمات عالی را روی دادههای آموزشی انجام دهد، اما نمیتواند به طور موثر پیشبینیها را برای دادههای اضافی تنظیم کند.

مشکل برعکس، عدم تناسب، زمانی رخ میدهد که مدل به اندازه کافی پیچیده نباشد تا بتواند پیشبینیهای دقیقی را نسبت به دادههای آموزشی یا دادههای جدید انجام دهد.

به طور خلاصه، وقتی پیشبینیهای خوبی در مجموعه دادههای آموزشی و مجموعه دادههای اعتبارسنجی مشاهده میکنید، میتوانید اطمینان داشته باشید که الگوریتم بر روی دادههای جدید، نه فقط یک زیرمجموعه کوچک از دادهها، همانطور که در نظر گرفته شده است، کار میکند.

داده های اعتبار سنجی در برابر داده های تست

همه دانشمندان داده هم به داده های اعتبارسنجی و هم به داده های آزمایشی اعتماد نمی کنند. تا حدودی، هر دو مجموعه داده یک هدف را دنبال می کنند: مطمئن شوید که مدل بر روی داده های واقعی کار می کند.

با این حال، برخی تفاوت های عملی بین داده های اعتبار سنجی و داده های آزمایشی وجود دارد. اگر تصمیم بگیرید که یک مرحله جداگانه برای تجزیه و تحلیل داده های اعتبار سنجی قرار دهید، این مجموعه داده معمولاً برچسب گذاری می شود تا دانشمند داده بتواند معیارهایی را جمع آوری کند که می توانند برای آموزش بهتر مدل از آنها استفاده کنند.

در این معنا، داده های اعتبارسنجی به عنوان بخشی از فرآیند آموزش مدل رخ می دهد. برعکس، زمانی که داده های آزمایشی را از طریق آن اجرا می کنید، این مدل به عنوان یک جعبه سیاه عمل می کند. بنابراین، دادههای اعتبارسنجی مدل را تنظیم میکند، در حالی که دادههای آزمایشی به سادگی کارکرد آن را تأیید میکند.

استاندارد سازی و نرمال سازی و پیش پردازش داده ها

«استاندارد کردن» یک بردار اغلب به معنای کم کردن یک اندازه از مکان و تقسیم بر یک مقیاس است. به عنوان مثال، اگر بردار حاوی مقادیر تصادفی با توزیع گاوسی باشد، ممکن است میانگین را کم کرده و بر انحراف استاندارد تقسیم کنید، در نتیجه یک متغیر تصادفی “عادی استاندارد” با میانگین 0 و انحراف استاندارد 1 به دست آورید.

“نرمال سازی” یک بردار اغلب به معنای تقسیم بر یک نرم بردار است. همچنین اغلب به تغییر مقیاس توسط حداقل و دامنه بردار اشاره دارد، تا همه عناصر بین 0 و 1 قرار بگیرند و بنابراین تمام مقادیر ستون های عددی در مجموعه داده را به یک مقیاس مشترک برساند.

داده های نویز و پیش پردازش داده ها

چرا باید به نویز داده و نویز برچسب در یادگیری ماشین اهمیت دهیم؟

دستاوردهای فوق العاده یادگیری ماشین را به برنامه های مختلف آورده است. این باید به تحقیق و کاربرد انگیزه و سرعت بخشد، زیرا اکنون میتوانیم به سؤالاتی که واقعاً مهم هستند در پزشکی، روانشناسی، جرمشناسی پاسخ دهیم. با این حال، این برنامه های کاربردی دنیای واقعی بیشتر از مشکلات آکادمیک پر سر و صدا هستند.

به عنوان مثال، در پزشکی، تشخیص های مختلف یک یا چند پزشک در یک نمونه پزشکی یک مشکل شناخته شده است، اگرچه نویز در مجموعه داده های دانشگاهی نیز وجود دارد. از سوی دیگر، گرایش به شبکه های بزرگتر منجر به مشکل به خاطر سپردن به جای تعمیم می شود که به خاطر سپردن نویز نیز ایجاد می شود.

مطالعات بیشتر در بخش راهنمای علمی سایت

کاراموزی های بیشتر در بخش کاراموزی های سایت